CPU性能监测:实时追踪处理器运行状态与关键效能指标分析

- 问答

- 2025-10-06 13:30:25

- 2

聊聊CPU性能监测:我是怎么揪出那个偷偷吃掉资源的“内鬼”的

说实话,一开始我对CPU性能监测这玩意儿也没太当回事,总觉得嘛,电脑卡了就重启一下,任务管理器随便瞄两眼,哪个进程占用高就结束掉——这不就完事了?🤷♂️ 直到去年写代码的时候,我的开发机突然频繁卡顿,风扇狂转得像要起飞,我才意识到:“瞎猜式排查”根本不行,得动真格的。

那时候我正在跑一个数据处理脚本,理论上半小时就该完事,结果愣是拖了两小时,我一开始以为是内存泄漏(毕竟Python偶尔会搞这种幺蛾子),但看了一眼内存占用,才50%不到,那就怪了……于是我终于打开了之前一直懒得学的perf工具(Linux平台下的性能分析神器),结果一看CPU的%soft指标(软中断占用率)飙到了30%!😳

软中断这么高,明显是内核在处理某些高频的硬件请求,我又用perf top看了一眼,发现一个叫iwlwifi的内核模块疯狂吃CPU——好家伙,原来是无线网卡驱动在抽风!后来查出来是电源管理配置和驱动版本冲突,导致网络包处理效率暴跌,CPU 不停地在处理中断请求,换用有线网络之后,CPU利用率直接从90%降到40%,脚本半小时跑完。

你看,这就是不抓指标光靠直觉的后果——我差点重装了系统,其实只是驱动的问题。

为什么要监测CPU?光看利用率可不够

很多人(包括之前的我)以为任务管理器里CPU利用率到100%到顶了”,但其实利用率高不一定代表有问题,比如一个正常编译任务吃满CPU是合理的,但如果你发现系统空闲时%system(系统态利用率)异常高,那可能就是内核在哪忙啥见不得人的事😏。

我后来养成了习惯,定期看这几个指标:

- 用户态 vs 系统态利用率(%user / %system):

system莫名很高,可能是驱动、内核线程或虚拟化层出问题了; - 软中断/硬中断频率(softirq / hardirq):

像我之前遇到的网卡问题,就是软中断炸了; - 上下文切换次数(context switch):

如果频繁切换,说明可能开了太多线程或调度策略不合理; - 每时钟指令数(IPC):

这是近几年我觉得最实用的指标之一——IPC低可能意味着CPU在“空等”(比如内存访问瓶颈)。

去年帮朋友调优一个游戏服务器的时候,就是发现IPC值一直低于1.0,最后发现是L3缓存命中率太低,换了CPU频率调度策略(从powersave改成performance)之后,帧率稳定性直接提升了20%。🎮

工具嘛,别只知道任务管理器

Windows下用PerfMon、Linux下用perf/htop、Mac下用Instruments——这些都是基础,但我个人最近特别喜欢用bpftrace(Linux 4.x以上内核支持),可以直接写脚本挂内核钩子,看函数级调用延迟。

比如有一次我写了一个多线程日志服务,理论上应该很轻量,但CPU就是不低,用bpftrace跟踪了一下pthread_mutex_lock的调用频率,发现某个锁的争用频率高达每秒5万次……锁粒度改细之后,CPU占用直接砍半。

不过说真的,工具再强,也抵不过“先怀疑自己的代码”这条定律,我后来发现,很多CPU性能问题其实源于业务逻辑的冗余——比如疯狂循环调用某个函数、频繁解析JSON、或者……嗯,在循环里写日志(别笑,我真干过这种事🙈)。

情绪化总结:CPU不会骗人,但你需要会问问题

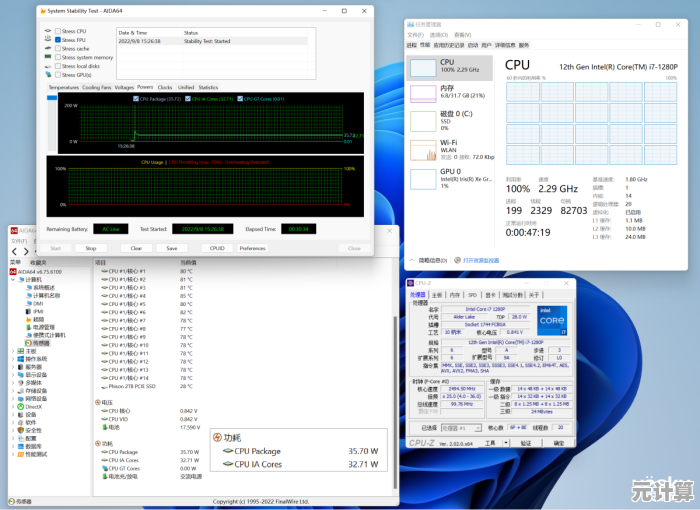

搞性能监测最大的误区,就是把它当成“标准流程”来跑——指标是死的,场景是活的,同样是CPU高,可能是算法问题、配置问题、硬件问题,甚至是散热问题(比如笔记本降频了)。

我现在养成了一个怪癖:一旦电脑卡了,先打开htop按S键看每个核心的IRQ占用,再按H看线程级状态……有点像侦探在案发现场找指纹🧐,虽然有点过度敏感,但真的能避免很多无用功。

最后扔一句真心话:不要相信“优化不重要”这种鬼话,或许在个人电脑上你感受不明显,但在服务器上,CPU利用率省下5%,可能意味着每月少烧几百块电费——或者半夜少接一个报警电话😴。

(完)

本文由但半青于2025-10-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://pro.xlisi.cn/wenda/55111.html