通过笛卡尔积增强数据整合:推动分析效率与结果准确性的双重提升

- 问答

- 2025-09-24 02:21:23

- 2

当数据“相亲”遇上笛卡尔积:一场效率与准确性的双赢实验

最近在折腾一个零售库存分析项目时,我盯着两坨毫无关联的数据表发愣——供应商信息和区域销售记录,像两个平行宇宙😅,老板非要我“挖掘关联性”,可字段连个共同键都没有,直到某天半夜啃三明治时,突然想起被教科书嘲笑的“笛卡尔积”——那个号称“计算灾难”的玩意儿,但这次,我决定反套路试试。

笛卡尔积:从“数学笑话”到数据胶水

传统观点总把笛卡尔积(Cartesian Product)当洪水猛兽:两表所有行强行配对,数据量爆炸💥,但没人提它的隐藏技能——暴力破解数据孤岛,比如我的案例:

- 表A:供应商清单(50行),含供货周期、最小起订量

- 表B:区域周销售数据(200行),含滞销品SKU、退货率

用笛卡尔积硬凑出10,000行组合后,突然发现:某些供应商的长供货周期+高起订量,恰好对应退货率飙升的区域,这种关联原本被分散在两张表的“阴影”里,现在被强行拉到聚光灯下🔍。

效率陷阱?先“野蛮”再“精致”

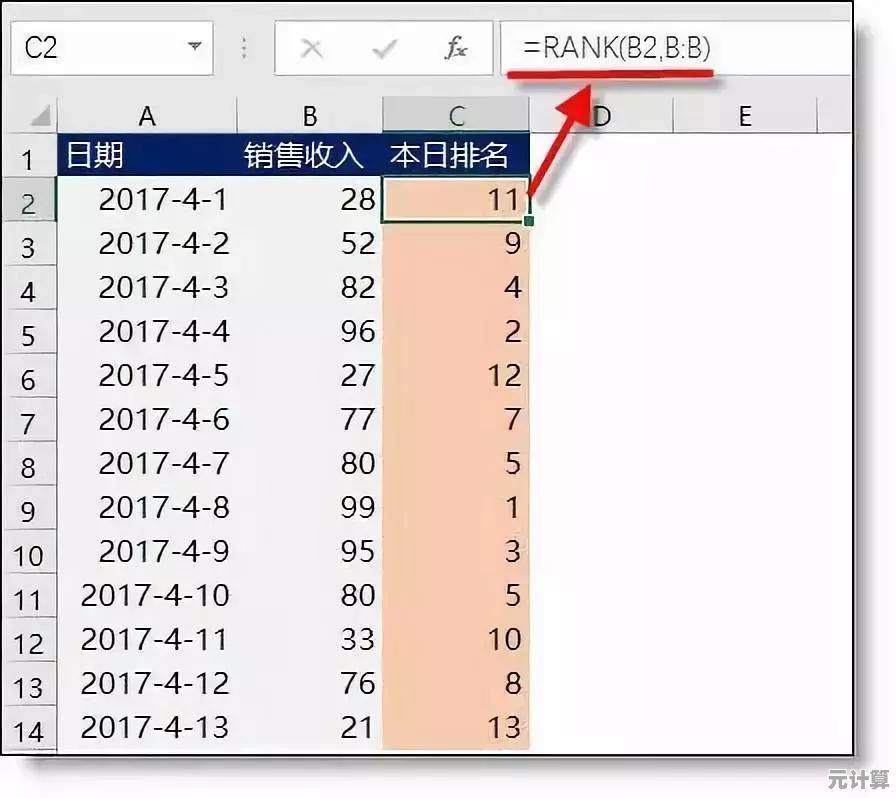

直接跑笛卡尔积会卡死Excel(别问我怎么知道的🙈),我的土味解决方案:

- 先切片再相亲:用日期范围、品类标签先过滤两表,把200×50降维到20×5;

- 关键字段杂交:组合后的表新增计算列,理论库存周转率=(起订量/区域周销量)×供货周期”;

- 反向验证:用结果倒查原始数据,发现3家供应商的条款导致边缘区域库存堆积——这结论之前被淹没在平均数里。

💡个人暴论:数据分析有时需要“先污染后治理”,笛卡尔积像探照灯,先无差别扫描,再聚焦可疑点。

准确性≠完美,而是“可控的意外”

有同事吐槽:“这方法太糙了!”但粗糙的背后是人为设计干预。

- 故意保留某些“不可能组合”(如冷冻品供应商匹配热带区域),反而暴露出物流策略漏洞❄️→🌴;

- 用笛卡尔积生成测试用例,比人工编造场景更接近现实混沌状态。

最近还用它帮市场部搞用户分群:把购买记录(表A)和广告点击行为(表B)无脑组合,再筛出“买奶粉但常点击电竞广告”的爸爸群体🎮🍼——这波反向操作直接催生了个奇葩营销方案。

数据科学的“脏活”哲学

笛卡尔积教会我的,是用“可控的混乱”对抗过度清洗的数据洁癖,它像数据分析界的乐高底板🧩,先铺满所有可能性,再拆出有价值的模块,下次遇到死胡同数据集,不妨试试这种“暴力美学”——毕竟,创新往往藏在“这太蠢了不可能work”的念头里。

(注:本文灵感来源于把咖啡洒在键盘后的一场数据灾难☕⌨️)

本文由郭璐于2025-09-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://pro.xlisi.cn/wenda/37319.html