探索虚拟内存机制:实现计算机存储资源灵活扩展的关键路径

- 问答

- 2025-10-06 05:03:18

- 2

让计算机“装得下”更多可能

记得第一次自己攒机的时候,盯着主板上的内存插槽发愣:只有两条DDR4,最大支持64GB,我当时想,要是跑大型渲染或者开一堆虚拟机,这点物理内存哪够用?结果朋友笑了:“你当虚拟内存是摆设啊?”——这句话像颗种子,让我开始琢磨这玩意儿到底是怎么“骗”过操作系统,让有限的内存条扛起远超自身容量的任务的。

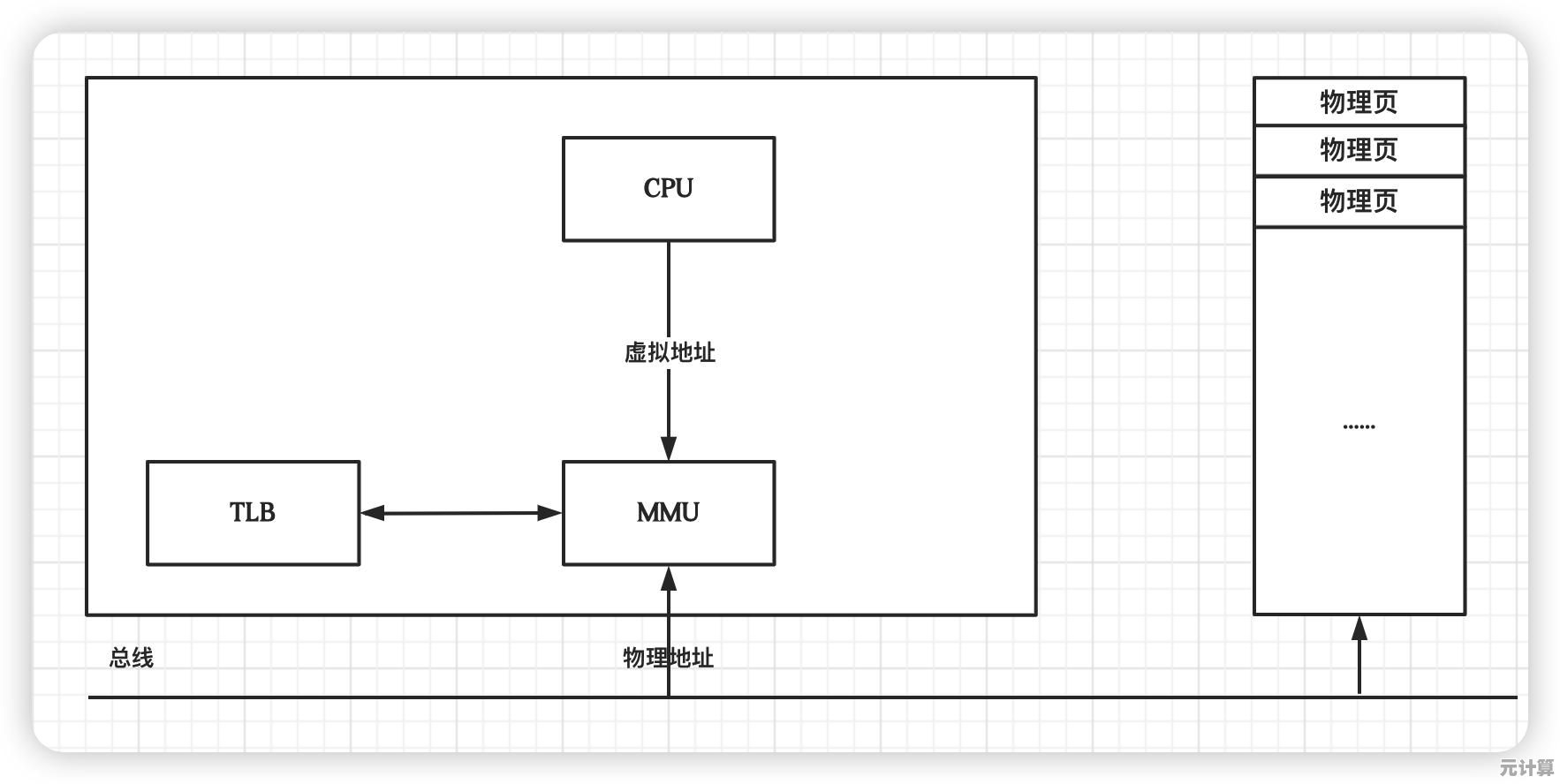

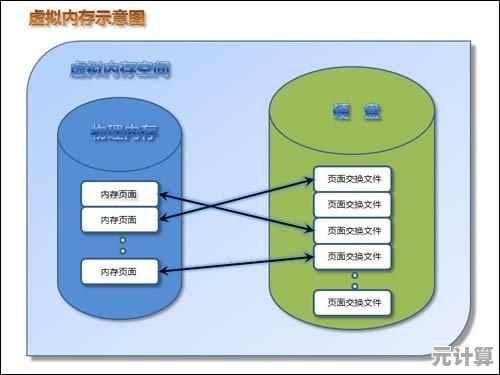

虚拟内存不是什么新概念,但它的设计思路至今仍然让人觉得“巧妙得有点狡猾”,本质上,它通过硬件(MMU)和操作系统(比如Linux的swap机制)配合,把物理内存和磁盘空间“粘”在一起,让进程以为自己独享一整块连续的内存地址,但有趣的是,这种“欺骗”背后全是妥协和权衡。

比如我的老笔记本,只有8GB内存,却经常同时开PyCharm、Chrome(20+标签页)、一个本地数据库和几个Docker容器,物理内存早爆了,但系统居然没崩——靠的就是虚拟内存把最少用的数据悄悄扔到硬盘上的swap分区,代价是什么?有时候切换标签页会卡一下,硬盘灯狂闪,这就是虚拟内存的阴暗面:用性能换空间,我记得有一次在赶项目时,机器突然卡成幻灯片,打开htop一看,swap用了快6GB,硬盘IO直接飙到100%,当时一边等响应一边骂街,但转念一想,要不是虚拟内存撑着,系统早崩了,活儿根本干不完。

虚拟内存的管理策略其实特别“人间真实”,比如页面置换算法,理想情况下应该精准踢掉“最近不会用”的页,但现实呢?Linux默认的LRU(最近最少使用)有时候也挺蠢的,我遇到过一种情况:后台跑着定时备份脚本,结果它频繁访问某个页面,导致LRU误以为这货很重要,反而把正在工作的前端页面换出去了,结果界面卡顿得更厉害,后来学了点内核调优,手动调了swappiness参数才缓解了点,你看,算法再聪明,也抵不过真实场景的混沌。

另一个让我印象深刻的是内存映射文件(mmap),之前写一个日志处理工具时,试过直接用mmap把几十GB的日志文件映射到虚拟地址空间,好处是读写像操作内存一样方便,不用手动读文件缓冲;但坑也不少——如果突然断电,脏页面可能没同步到磁盘,数据就丢了,当时在文档里看到“mmap不保证持久化”时冷汗都出来了,赶紧加了fsync补救,这种细节教科书很少强调,全靠踩坑。

虚拟内存还暴露了硬件和软件之间的“默契成本”,比如TLB(转址旁路缓存)miss时的性能惩罚,或者不同架构(x86 vs. ARM)的页表设计差异,有一次在树莓派上跑镜像,明明物理内存够用,却频繁触发swap,后来发现是ARM的二级页表查询开销太大,不得不重新编译内核调整页大小,这种问题在开发板上很常见,但PC用户可能一辈子遇不到——虚拟内存的实现细节居然能这么“看人下菜碟”。

说到底,虚拟内存不是什么完美方案,而是一种带着镣铐的舞蹈,它用空间换时间(或者反过来),用复杂度换灵活性,甚至偶尔会“耍小聪明”出错,但正是这种不完美,让它成了现代系统的基石,每次我的破笔记本在内存告急时苟延残喘,我都觉得这机制像是个老练的杂技演员,手里抛着十几个球,明明快掉了,但总能在坠地前捞回来。

也许技术就是这样:没有银弹,只有权衡和适应,虚拟内存未必优雅,但它让我的8GB老机器至今还能战,这就够了。

本文由汪微婉于2025-10-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://pro.xlisi.cn/wenda/54574.html